Deep fakes. Com la intel·ligència artificial pot generar notícies falses

Tot comença amb una pregunta, com la que plantejava Lola Flores en el que semblava un vídeo inèdit que va veure la llum el 2021. “Tu saps per què a mi em van entendre a tot el món? Per l’accent”, deia l’artista, morta el 1995, mirant directament a càmera. Aquestes imatges, que semblaven reals però que no ho eren, formaven part d’un anunci d’una marca de cervesa, com un exemple excel·lent del que pot fer la intel·ligència artificial (IA).

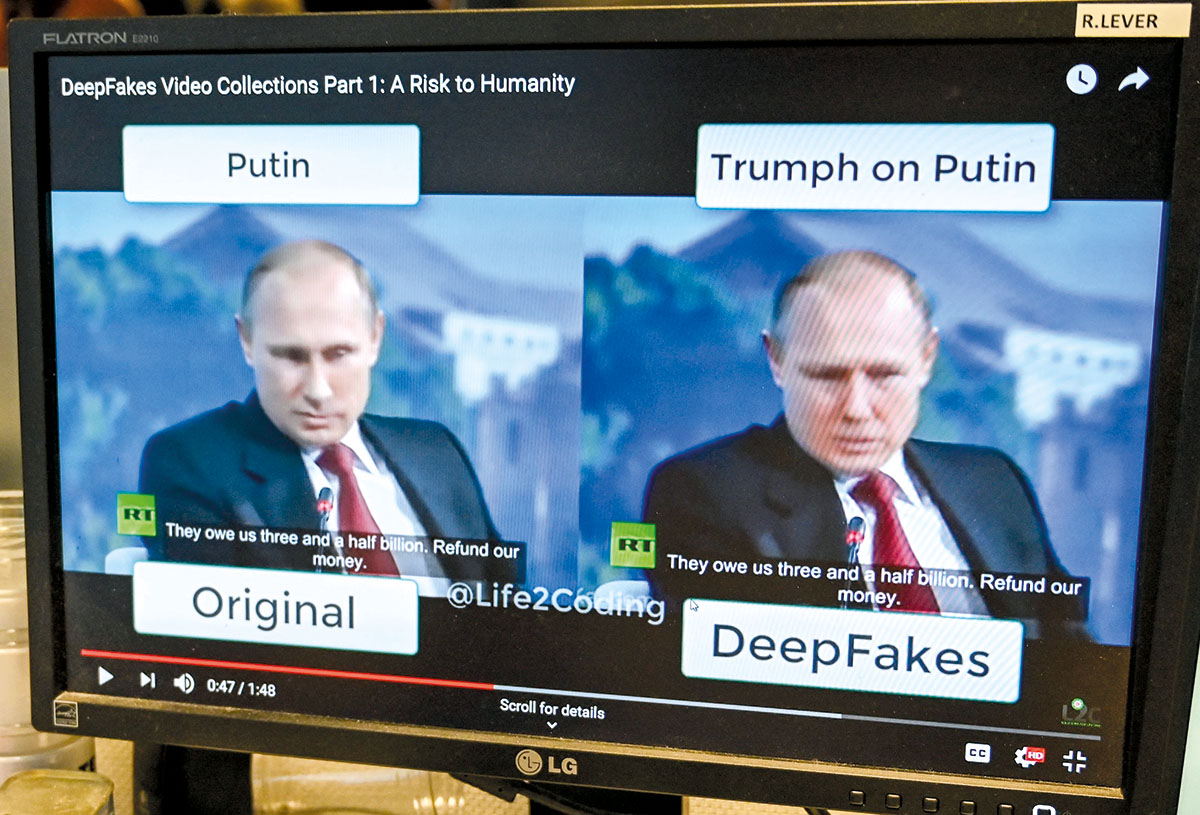

La tecnologia que ho va fer possible es coneix com a deepfake, una tècnica d’intel·ligència artificial que, a partir de vídeos i imatges preexistents i mitjançant un programari d’aprenentatge automàtic i algorismes conegut com GAN (“Generative Adversarial Networks”, o xarxes generatives adversàries), permet crear vídeos, imatges o arxius de veu manipulats i falsos, però amb aparença real i autèntica. I aquí hi ha el perill.

L’origen d’una mentida

“Podríem definir els deepfakes com a continguts, textuals o audiovisuals, generats artificialment i que no es corresponen amb la realitat. Poden ser notícies falses fabricades o vídeos en els quals s’incorpora la cara d’una persona en una escena on no participa. El més habitual és tot el que té relació amb l’àmbit polític, però, avui dia, els continguts falsos i de poca credibilitat o incorrectes són molt presents al web i a les xarxes socials”, assenyala David Losada, professor de Ciències de la Computació i Intel·ligència Artificial a la Universitat de Santiago de Compostel·la i investigador del Centre Singular d’Investigació en Tecnologies Intel·ligents (CiTIUS).

Hi ha diferents categories de deepfakes, entre les quals en destaquen tres: face-swap (intercanvi de cares), lip-sync (sincronització de llavis amb un missatge d’àudio) i puppet master (titella virtual). Els primers vídeos manipulats per intel·ligència artificial dels quals es té constància es remunten als anys noranta, però van saltar a la fama el 2017, quan un fil de la plataforma de notícies Reddit va publicar vídeos de contingut adult amb la cara d’actrius famoses.

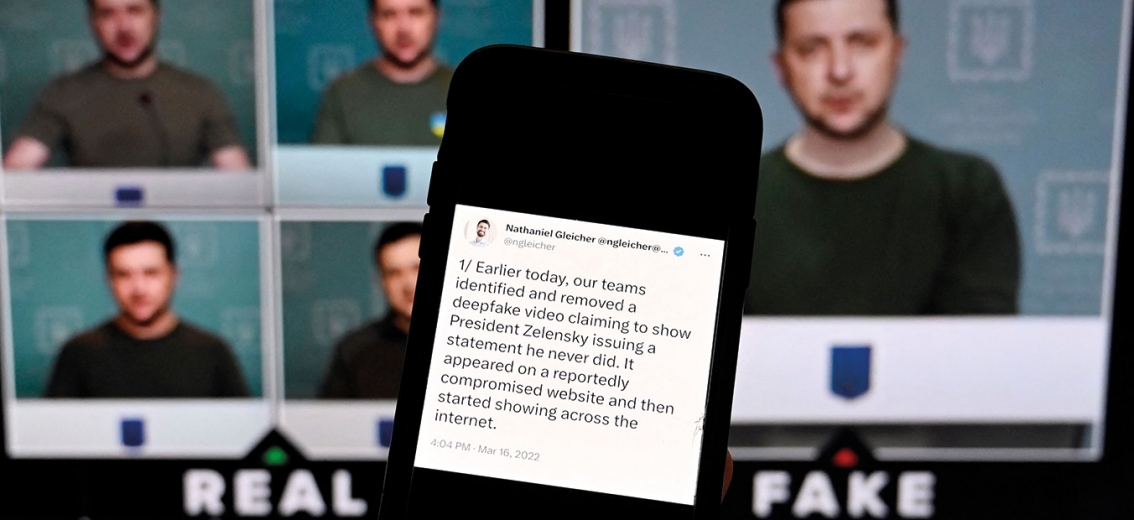

No va acabar aquí. Vídeos d’alts càrrecs polítics i presidents llançant falsedats que no han dit mai o empresaris famosos anunciant compres milionàries falses són alguns dels exemples en què el deepfake pot portar a la desinformació i crispació social, política o econòmica, atemptar contra la intimitat i l’honor de les víctimes dels muntatges falsos o fins i tot fer ús de la intel·ligència artificial per a cometre un altre tipus de delictes. A finals de 2022 es va detenir a Valladolid un pedòfil que feia servir la mateixa tecnologia per crear deepfakes d’abús sexual infantil. Al març de 2023, Facebook i Instagram es van omplir d’anuncis d’una aplicació, DeepFake FaceSwap, que feia servir com a ganxo les cares de les actrius famoses en vídeos falsos de contingut pornogràfic.

Encara que els deepfakes són difícils de destapar, hi ha alguns senyals que ens poden ajudar:

- Errades. Molts presenten errors que delaten que s’ha manipulat el vídeo: vores borroses, pell llisa artificialment, moviments entretallats o diferències en la il·luminació són alguns.

- Parpelleig. En un deepfake, una persona parpelleja menys vegades de les que ho faria una persona en un vídeo real. Això és perquè l’algorisme no és capaç de parpellejar sense evidenciar indicis de falsedat, almenys, igual de de pressa que un ésser humà.

- Coll i cara. Aquests vídeos solen modificar només les cares, no el cos sencer, ja que això és més complicat. Si el que es veu del cos no coincideix amb la cara, podem tenir una pista més que és un vídeo fals.

- So. Moltes vegades la imatge no s’ajusta correctament amb la veu, per tant no hi ha una sincronització entre el moviment dels llavis i el so.

- Detalls. És important conèixer tota la informació sobre l’enregistrament i, per a fer-ho, pot ajudar reproduir el vídeo a velocitat reduïda. Si es tracta d’un deepfake, podrem veure modificacions sobtades en la imatge o canvis en el fons del vídeo.

- Boca. Els algorismes d’intel·ligència artificial encara no poden copiar amb precisió la llengua, les dents i l’interior de la boca quan parlem. Un petit error en aquesta part ens indica que som davant d’un vídeo manipulat.

- Origen. Esbrinar qui ha compartit l’arxiu en primera instància i en quines xarxes socials, i també verificar el context en què s’ha publicat i els detalls originals, ens poden ajudar a detectar-lo.

- Durada. La majoria dels deepfakes tenen una durada molt curta, d’uns segons. Un vídeo massa curt i amb un contingut inversemblant també ens pot donar una pista.

Com es poden identificar

Els experts recomanen fer servir el sentit comú i el pensament crític davant de qualsevol imatge o vídeo fora del comú. Els mitjans de comunicació tradicionals tenen equips de verificadors que intenten distingir les imatges manipulades de les reals —com va passar recentment en la guerra d’Ucraïna— i la recomanació és acudir a fonts oficials, que abans o després desmentiran la informació falsa. També es pot observar si en el vídeo d’una persona veiem un parpelleig inexistent o dessincronitzat, perfils d’orelles borroses o multiplicades, nassos i mans distorsionats o pèrdua de nitidesa.

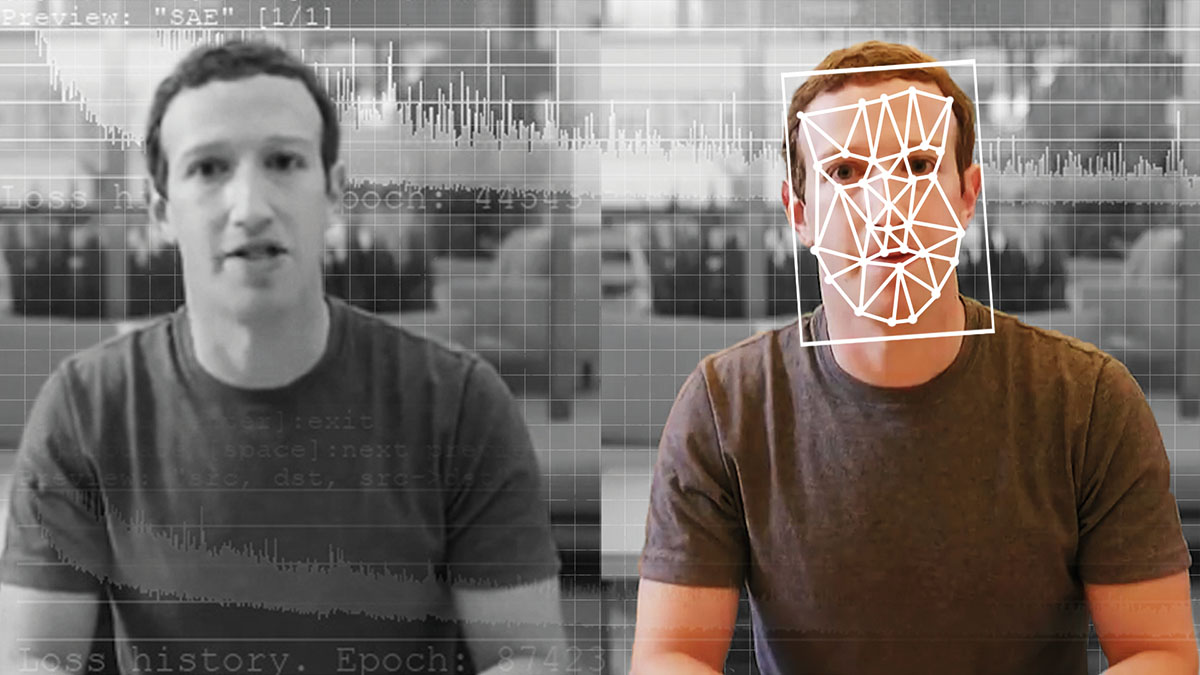

De la mateixa manera que hi ha aplicacions perquè el públic general, sense coneixements informàtics, experimenti amb la intel·ligència artificial per a crear deepfakes, les grans companyies tecnològiques desenvolupen aplicacions que volen destapar la desinformació, en una carrera contrarellotge contra l’ús maliciós d’aquesta tecnologia.

“Encara no hi ha eines ni programes que puguin analitzar, en temps real, tota mena de continguts, en qualsevol format i plataforma perquè l’espectador pugui distingir un vídeo vertader d’un de fals. És una àrea incipient en què cada dia sorgeixen amenaces noves, encara que sí que hi ha projectes d’estudi, en l’entorn acadèmic i empresarial, per a lluitar-hi en contra, perquè les grans companyies són les primeres que estan interessades a donar un servei d’accés a informació de qualitat. Moltes de les eines automàtiques són d’aprenentatge supervisat, amb casos de deepfake reals, intentes ensenyar el sistema a distingir la veritat de la falsedat”, insisteix Losada.

En aquesta línia treballen projectes com el programa Video Authenticator de Microsoft, o l’algorisme TREAD (Terrorism Reduction with Artificial Intelligence Deepfakes), creat per la Brookings Institution i la Universitat Northwestern dels Estats Units, que pretén capacitar els serveis militars i d’intel·ligència dels països per a crear i entendre la tecnologia deepfake. Un altre exemple és la Coalició per a la Procedència i Autenticitat del Contingut, impulsada per multinacionals tecnològiques amb l’objectiu de lluitar contra la desinformació i desenvolupar estàndards tècnics que permetin certificar la procedència dels continguts digitals.

- Canvi de cara (face-swap)

Intercanvi facial que substitueix la cara original per una altra, tant si és d’un personatge real com si és fictici. Es pot fer en imatge fixa, vídeo o retransmissió en directe, com permeten aplicacions mòbils com Snapchat o Face Swap Live.

L’empresa de contingut generat per intel·ligència artificial Metaphysic ha aconseguit alguns dels millors exemples d’aquesta tecnologia, com el compte viral de TikTok @ DeepTomCruise o la seva intervenció en el programa televisiu America’s Got Talent, on van fer servir aquesta tecnologia per a transformar, en directe, la cara d’un concursant en el cos del presentador. També van tornar a la vida el cantant Elvis Presley en una actuació en directe gràcies a aquesta tecnologia. - Una nova veu (lip-sync)

A partir d’un vídeo preexistent, se substitueix el contingut d’àudio per simular que dona un missatge diferent. La nova cara encaixarà de tal forma que es faci una sincronització labial.

Un exemple és l’experiment visual plantejat per BuzzFeed Video en què el president Barack Obama apareixia en un vídeo llançant un missatge d’advertiment sobre els deepfakes. Els últims segons es revelava la tècnica de lip-sync i l’actor que en realitat estava pronunciant aquest missatge. - Fusió de dues persones (puppet-master)

És un dels deepfakes més difícils i de resultats sorprenents, que consisteix a utilitzar el cos d’un actor com a base per a crear un vídeo nou, al qual se superposa i es fusiona la imatge d’una altra persona. Si, a més, s’hi afegeixen efectes d’àudio que recuperin la veu del personatge original, el deepfake encara serà més difícil de detectar.

Un exemple és l’anunci de Lola Flores per a una marca de cerveses, on en primer lloc es va gravar com a cos base una cantaora amb aparença similar a Lola Flores. Després, el deepfake va requerir més de 5.000 imatges d’arxiu de l’artista, centenars d’hores de postproducció, amb ajustaments per a assegurar la versemblança de la model, efectes especials i la veu de la seva filla.

Destapant la realitat

En aquesta línia d’investigació, Espanya forma part d’un projecte pioner, liderat pel CiTIUS i conegut com a HYBRIDS: intel·ligència híbrida per a monitorar, promoure i analitzar transformacions en les bones pràctiques democràtiques. És a dir: humans i màquines que lluiten junts contra la desinformació, les notícies falses i els discursos d’odi. Aquesta iniciativa, cofinançada per la Unió Europea i l’agència UK Research and Innovation del Regne Unit, aporta l’anàlisi científica que pugui contrarestar les amenaces de la desinformació. Com ho aconseguirà? Amb el desenvolupament de noves eines automàtiques, basades en el processament del llenguatge natural (PLN) i la intel·ligència artificial, aplicant tècniques de deep learning (aprenentatge profund). “L’objectiu és generar nous sistemes d’interpretació neurosimbòlica, el que coneixem com a “intel·ligència híbrida”, que consisteix a combinar les altes capacitats computacionals dels algorismes neuronals amb el coneixement humà, per a superar les mancances dels mètodes actuals d’intel·ligència artificial”, descriu Pablo Gamallo, expert en lingüística computacional i responsable d’HYBRIDS a Espanya.

Així es verifica

La dificultat per a l’espectador a l’hora d’identificar la manipulació visual és el consum ràpid de contingut en xarxes socials, la falta de pensament crític que ens fa caure en notícies falses i la mateixa dificultat tècnica per a diferenciar el contingut fals del real. El creixement dels deepfakes és exponencial, gairebé es duplica cada sis mesos des de 2018, segons un informe de Sensity, empresa dedicada a la detecció i verificació de continguts.

“Tenim alguns casos recents, molt visuals, de deepfake. Un exemple podrien ser les fotografies de les manifestacions a França de febrer de 2023 on apareixien agents antidisturbis que consolaven manifestants o amb un osset de peluix. Va passar? No. Eren imatges generades íntegrament per intel·ligència artificial, amb un cert toc innocent, però, què hauria passat si en comptes d’una abraçada es comparteix la imatge de suposades accions violentes, que donen peu a disturbis?”, planteja Miguel Hernández Boza, analista de seguretat informàtica, especialitzat en detecció de frau i seguretat defensiva.

De fet, les fotografies fictícies de les manifestacions contra la reforma de la jubilació a França van ser desmentides ràpidament per l’experta en verificació Nina Lamparski, directora de la plataforma AFP FastCheck. La pista definitiva? Una cara amb una orella doble i mans amb sis dits. A la intel·ligència artificial encara li costa dissenyar alguns aspectes de la fisonomia humana, però obre un nou front dels periodistes i verificadors d’informació, que en el futur hauran de contrastar totes les imatges que rebin com a suposadament reals i detectar aquest tipus d’errors.

“DARPA, l’Agència de Projectes d’Investigació Avançats de Defensa dels Estats Units, és qui més ha avançat en la investigació. Ja van predir fa anys que el perill més gran a què es pot enfrontar la societat és la combinació de veus, vídeo i imatges per a crear esdeveniments falsos. Aquest treball de DARPA podria servir de base a altres projectes internacionals que lluiten contra la desinformació, per a no començar de zero. Es podria continuar a partir de la seva experiència en facilitar-ne la detecció, millorar els sistemes, portar aquesta anàlisi a tota mena de contingut audiovisual, a nivell global”, valora Hernández Boza. I adverteix que el pròxim repte ja no serà només tractar d’identificar un vídeo fals, sinó demostrar que un vídeo és real. “Pot ser que t’enxampin cometent alguna acció il·lícita i que tu ho neguis, assegurant que és un deepfake, encara que realment t’hagin enxampat. Això donarà els mateixos problemes. Necessitarem identificar i demostrar que el vídeo és real, amb metadades, amb diverses fonts, per a comprovar que no s’ha manipulat. Per tant, la dificultat resideix no només a detectar contingut fals, sinó a validar el contingut real: demostrar que no s’ha manipulat i que va passar de debò”, conclou.

Més de 1.000 empresaris i investigadors relacionats amb la intel·ligència artificial –com el fundador de Tesla, Elon Musk, o el cofundador d’Apple, Steve Wozniak–, van publicar a finals de març una carta oberta on sol·licitaven una moratòria d’almenys sis mesos en el desenvolupament d’aquesta tecnologia. La raó: els últims avanços ja poden competir amb els humans, per tant es podrien utilitzar per a destruir ocupació i difondre desinformació. Reclamen un desenvolupament segur que comprovi que els seus efectes seran positius.

A Europa s’estan fent els primers passos per regular el futur incert d’aquest tipus de tecnologia, amb el desenvolupament del Reglament d’Intel·ligència Artificial (The AI Act), que encara s’està debatent a la Unió Europea. Quan entri en vigor serà la primera llei que tingui com a objectiu garantir que els sistemes i aplicacions d’intel·ligència artificial que funcionin a Europa siguin segurs i respectin els drets fonamentals i els valors de la Unió, al mateix temps que aportarà un marc jurídic i legal uniforme, que hauran d’implantar i traslladar els Estats membres a les seves respectives normatives.

Espanya ha estat el primer país que ha anunciat la creació de l’Agència Espanyola de Supervisió de la Intel·ligència Artificial (AESIA), que tindrà potestat certificadora i sancionadora, i vetllarà pel compliment del futur reglament europeu. La intenció era que l’AESIA comencés a treballar a l’estiu de 2023, a la seu designada a la Corunya, però la societat civil Juntos por Granada i el mateix Ajuntament de la ciutat andalusa –que competien amb d’altres per allotjar aquesta seu– han impugnat la designació i n’han alentit la posada en marxa.

“Encara s’ha de veure quines atribucions tindrà l’AESIA i com s’implementarà la regulació europea. L’aposta a Espanya parteix del fet que les empreses tinguin uns protocols de seguretat que es puguin auditar. L’AESIA hauria de crear una eina de certificació, com un segell de qualitat. Si una empresa aconsegueix aquest certificat, podrà demostrar que ho fa bé i els ciutadans podran confiar en el seu producte. Un organisme de certificació, emparat per l’AESIA, hauria de tenir personal amb coneixement tècnic necessari per a demostrar, de manera transparent, que es fa un treball d’acord amb uns principis ètics i a la legislació en vigor. I, si no és així, penalització, multes o retirar aquest segell”, reflexiona José María Alonso, professor de Ciències de la Computació i Intel·ligència Artificial en la Universitat de Santiago de Compostel·la i investigador del CiTIUS.

Els professionals que treballin en la futura AESIA tindran perfils tècnics i jurídics, especialitzats en noves tecnologies i seguretat informàtica. De tota manera, José María Alonso recorda la necessitat d’afegir a aquests perfils professionals d’altres disciplines, com ara lingüística, sociologia o medicina, que aportin la seva visió sobre possibles usos i abusos de la intel·ligència artificial. “No es pot fer una regulació que només es basi en el coneixement d’enginyers i advocats. Hauria d’haver-hi panels de discussió, on es combinin totes les visions, per a fer un desenvolupament multidisciplinari inclusiu”, afirma.