Deep fakes. Cómo la inteligencia artificial puede generar noticias falsas

Todo empieza con una pregunta, como la que planteaba Lola Flores en lo que parecía un vídeo inédito que vio la luz en 2021. “¿Tú sabes por qué a mí se me entendió en todo el mundo? Por el acento”, decía la artista, fallecida en 1995, mirando directamente a cámara. Estas imágenes, que parecían reales, pero no lo eran, formaban parte de un anuncio de una marca cervecera, como excelente ejemplo de lo que la inteligencia artificial (IA) puede hacer.

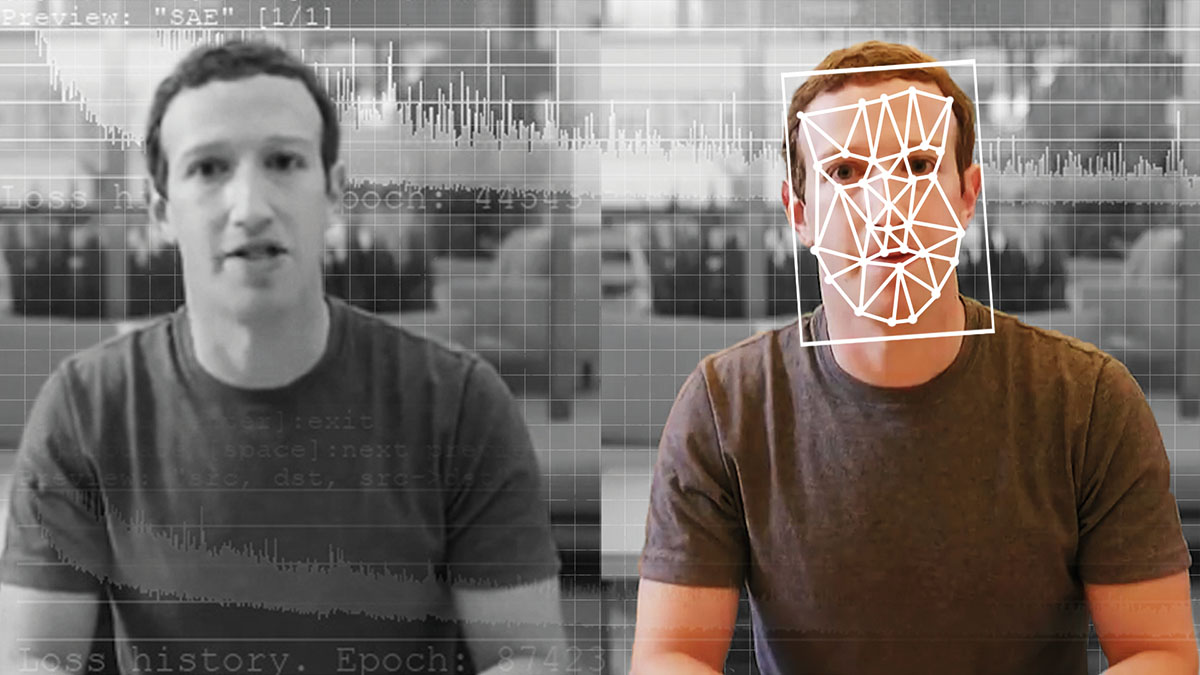

La tecnología que lo hizo posible se conoce como deepfake, una técnica de inteligencia artificial que, a partir de vídeos e imágenes preexistentes y mediante software de aprendizaje automático y algoritmos conocidos como RGA (Redes Neuronales Generativas Adversarias), permite la creación de vídeos, imágenes o archivos de voz manipulados y falsos, pero con apariencia real y auténtica. Y ahí está el peligro.

El origen de una mentira

“Podríamos definir los deepfakes como contenidos, textuales o audiovisuales, generados artificialmente y que no se corresponden con la realidad. Pueden ser noticias falsas fabricadas o vídeos en los que se incorpora la cara de una persona en una escena en la que no está participando. Lo más habitual es todo lo relacionado con el ámbito político, pero hoy en día, los contenidos falsos y de poca credibilidad o incorrectos están muy presentes en la web y redes sociales”, señala David Losada, profesor de Ciencias de la Computación e Inteligencia Artificial en la Universidad de Santiago de Compostela e investigador del Centro Singular de Investigación en Tecnoloxías Intelixentes (CiTIUS).

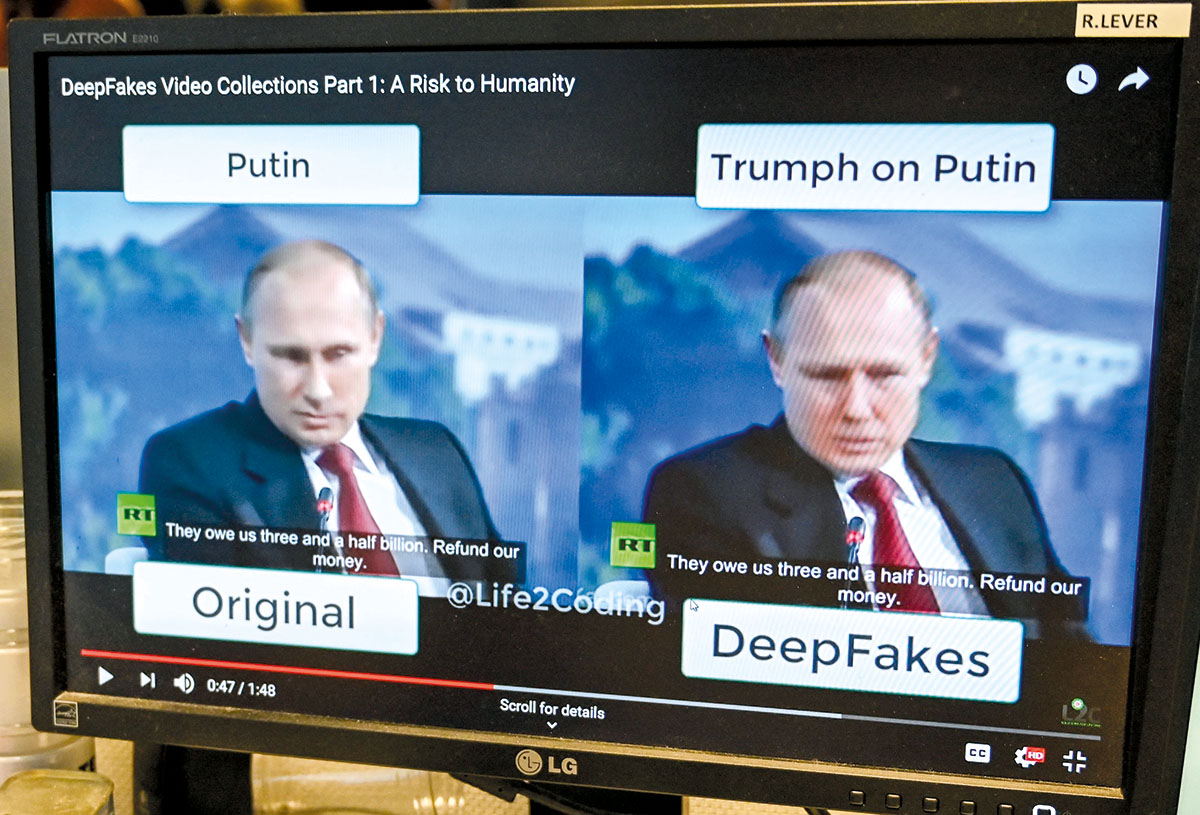

Existen distintas categorías de deepfakes, entre las que destacan tres: face-swap (intercambio de rostros), lip-sync (sincronización de labios con un mensaje de audio) y puppet master (marioneta virtual). Los primeros vídeos manipulados por inteligencia artificial de los que se tiene constancia se remontan a los años noventa, pero saltaron a la fama en 2017, cuando un hilo de la plataforma de noticias Reddit publicó vídeos de contenido adulto con el rostro de actrices famosas.

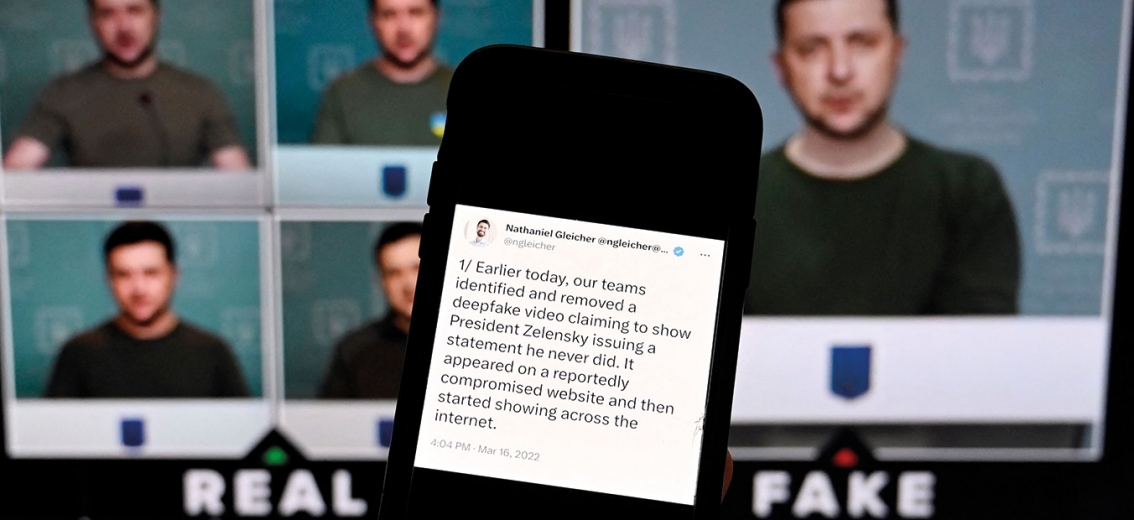

No acabó ahí. Vídeos de altos cargos políticos y presidentes lanzando soflamas que nunca pronunciaron o famosos empresarios anunciando falsas compras millonarias son algunos de los ejemplos en los que el deepfake puede llevar a la desinformación y crispación social, política o económica, atentar contra la intimidad y el honor de las víctimas de los montajes falsos o incluso emplear la inteligencia artificial para cometer otro tipo de delitos. A finales de 2022 se detuvo en Valladolid a un pedófilo que empleaba la misma tecnología para crear deepfakes de abuso sexual infantil. En marzo de 2023, Facebook e Instagram se llenaron de anuncios de una aplicación, DeepFake FaceSwap, que utilizaba como gancho los rostros de las actrices famosas en falsos vídeos de contenido pornográfico.

Aunque los ‘deepfakes’ son difíciles de destapar, hay algunas señales que nos pueden ayudar:

- Fallos. Muchos poseen errores que delatan que se ha manipulado el vídeo: bordes borrosos, piel artificialmente lisa, movimientos entrecortados o diferencias en la iluminación son algunos de ellos.

- Parpadeo. En un deepfake, una persona parpadea menos veces de las que lo haría una persona en un vídeo real. Esto se debe a que el algoritmo no es capaz de parpadear sin evidenciar indicios de falsedad, por lo menos igual de rápido que un ser humano.

- Cuello y cara. Estos vídeos suelen modificar solo los rostros, no el cuerpo entero, ya que esto es más complicado. Si lo que se ve del cuerpo no coincide con la cara, podemos tener una pista más de que se trata de un vídeo falso.

- Sonido. Muchas veces la imagen no se ajusta correctamente con la voz, por lo que no hay una sincronización entre el movimiento de los labios y el sonido.

- Detalles. Es importante conocer toda la información sobre la grabación y, para esto, puede ayudar reproducir el vídeo a velocidad reducida. Si se trata de un deepfake, podremos ver modificaciones repentinas en la imagen o cambios en el fondo del vídeo.

- Boca. Los algoritmos de inteligencia artificial todavía no son capaces de copiar con precisión la lengua, los dientes y el interior de la boca al hablar. Un pequeño fallo en esta parte nos indica que estamos ante un vídeo manipulado.

- Origen. Indagar sobre quién compartió el archivo en primera instancia y en qué redes sociales, así como verificar el contexto en que se publicó y los detalles originales del mismo, pueden ayudarnos a detectarlo.

- Duración. La mayoría de los deepfakes tienen una duración muy corta, de unos segundos. Un vídeo demasiado corto y con un contenido inverosímil puede darnos también una pista.

Cómo identificarlos

Los expertos recomiendan utilizar el sentido común y pensamiento crítico ante cualquier imagen o vídeo fuera de lo común. Los medios de comunicación tradicionales tienen equipos de verificadores que intentan distinguir las imágenes manipuladas de las reales —como sucedió recientemente en la guerra de Ucrania— y la recomendación es acudir a fuentes oficiales, que antes o después desmentirán la información falsa. También se puede observar si en el vídeo de una persona vemos un parpadeo inexistente o desincronizado, perfiles de orejas borrosas o multiplicadas, nariz y manos distorsionadas o pérdida de nitidez.

De la misma forma que existen aplicaciones para que el público general, sin conocimientos informáticos, experimente con la inteligencia artificial para crear deepfakes, grandes compañías tecnológicas están desarrollando aplicaciones que buscan destapar la desinformación, en una carrera contrarreloj contra el uso malicioso de esta tecnología.

“Todavía no existen herramientas o software que puedan analizar, en tiempo real, todo tipo de contenidos, cualquier formato y plataforma para que el espectador pueda distinguir un vídeo verdadero de uno falso. Es un área incipiente en la que aparecen nuevas amenazas cada día, aunque sí existen proyectos de investigación, en el entorno académico y empresarial, para luchar contra ello, porque las grandes compañías son las primeras interesadas en dar un servicio de acceso a información de calidad. Muchas de las herramientas automáticas son de aprendizaje supervisado, con casos de deepfake reales, tratas de enseñar al sistema a distinguir lo cierto de lo falso”, abunda Losada.

En esta línea trabajan proyectos como el programa Video Authenticator de Microsoft, o el algoritmo TREAD (Terrorism Reduction with Artificial Intelligence Deepfakes), creado por la Brookings Institution y la Universidad Northwestern de Estados Unidos, que pretende capacitar a los servicios militares y de inteligencia de los países para crear y entender la tecnología deepfake. Otro ejemplo es la Coalición para la Procedencia y Autenticidad del Contenido, impulsada por multinacionales tecnológicas con el objetivo de luchar contra la desinformación y desarrollar estándares técnicos que permitan certificar la procedencia de los contenidos digitales.

- Cambio de cara. ‘Face-swap’

Intercambio facial que sustituye el rostro original por otro, sea de un personaje real o ficticio, que se puede realizar en imagen fija, vídeo o retransmisión en directo, como permiten aplicaciones móviles como Snapchat o Face Swap Live.

La empresa de contenido generado por inteligencia artificial, Metaphysic, ha conseguido algunos de los mejores ejemplos de esta tecnología, como la cuenta viral de TikTok @DeepTomCruise o su intervención en el programa televisivo America’s Got Talent, en el que emplearon esta tecnología para transformar, en directo, el rostro de un concursante en el cuerpo del presentador. También devolvieron a la vida al cantante Elvis Presley en una actuación en directo gracias a esta tecnología. - Una nueva voz. ‘Lip-sync’

A partir de un vídeo preexistente, se sustituye el contenido de audio para simular que da un mensaje diferente. La nueva cara encajará de tal forma que se haga una sincronización labial.

Un ejemplo es el experimento visual planteado por BuzzFeed Video, en el que el presidente Barack Obama aparecía en un vídeo lanzando un mensaje de advertencia sobre los deepfakes. En los últimos segundos se desvelaba la técnica de lip-sync y el actor que en realidad estaba pronunciando ese mensaje. - Fusión de dos personas. ‘Puppet-master’

Es uno de los deepfakes más difíciles y de resultados asombrosos, que consiste en utilizar el cuerpo de un actor como base para crear un vídeo nuevo, al que se superpone y fusiona la imagen de otra persona. Si, además, a esto se añaden efectos de audio que recuperen la voz del personaje original, el deepfake será aún más difícil de detectar.

Un ejemplo es el anuncio de Lola Flores para una marca de cervezas, en el que primero se grabó como cuerpo base a una cantaora con aparencia similar a Lola Flores. Después, el deepfake requirió más de 5.000 imágenes de archivo de la artista, cientos de horas de posproducción, con ajustes para asegurar la verosimilitud del modelo, efectos especiales y la voz de su hija.

Destapando la realidad

En esa línea de investigación, España forma parte de un proyecto pionero, liderado por el CiTIUS y conocido como HYBRIDS: Inteligencia híbrida para monitorizar, promover y analizar transformaciones en las buenas prácticas democráticas. Es decir: humanos y máquinas luchando juntos contra la desinformación, noticias falsas y discursos de odio. Esta iniciativa, cofinanciada por la Unión Europea y la agencia UK Research and Innovation del Reino Unido, aporta el análisis científico que pueda contrarrestar las amenazas de la desinformación. ¿Cómo lo conseguirá? A través del desarrollo de nuevas herramientas automáticas, basadas en el procesamiento del lenguaje natural (PLN) y la inteligencia artificial, aplicando técnicas de deep learning (aprendizaje profundo). “El objetivo es generar nuevos sistemas de interpretación neurosimbólica, algo que conocemos como ‘inteligencia híbrida’, que consiste en combinar las altas capacidades computacionales de los algoritmos neuronales con el conocimiento humano, para superar las carencias de los actuales métodos de inteligencia artificial”, describe Pablo Gamallo, experto en lingüística computacional y responsable de HYBRIDS en España.

Así se verifica

La dificultad para el espectador a la hora de identificar la manipulación visual es el consumo rápido de contenido en redes sociales, la falta de pensamiento crítico que hace caer en bulos y la propia dificultad técnica para diferenciar el contenido falso del real. El crecimiento de los deepfakes está siendo exponencial, casi duplicándose cada seis meses desde 2018, según un informe de Sensity, empresa dedicada a la detección y verificación de contenidos.

“Tenemos algunos casos recientes, muy visuales, de deepfake. Un ejemplo podrían ser las fotografías de las manifestaciones en Francia de febrero de 2023 en las que aparecían agentes antidisturbios consolando a manifestantes o llevando un osito de peluche. ¿Sucedió? No. Eran imágenes generadas íntegramente por inteligencia artificial, con cierto toque inocente, pero, ¿qué habría sucedido si en vez de un abrazo se comparte la imagen de supuestas acciones violentas, que dan pie a disturbios?”, plantea Miguel Hernández Boza, analista de seguridad informática, especializado en detección de fraude y seguridad defensiva.

De hecho, las fotografías ficticias de las manifestaciones contra la reforma de la jubilación en Francia fueron rápidamente desmentidas por la experta en verificación Nina Lamparski, directora de la plataforma AFP FastCheck. ¿La pista definitiva? Un rostro con oreja doble y manos con seis dedos. A la inteligencia artificial todavía le cuesta diseñar algunos aspectos de la fisonomía humana, pero abre un nuevo frente a los periodistas y verificadores de información, que en el futuro deberán contrastar todas las imágenes que reciban como supuestamente reales y detectar ese tipo de errores.

“DARPA, la Agencia de Proyectos de Investigación Avanzados de Defensa de Estados Unidos, es quién más ha avanzado en la investigación. Ya predijeron hace años que el mayor peligro al que se puede enfrentar la sociedad es la combinación de voces, vídeo e imágenes para crear eventos falsos. Este trabajo de DARPA podría servir de base a otros proyectos internacionales que luchan contra la desinformación, para no empezar de cero. Se podría continuar a partir de su experiencia sobre cómo facilitar la detección, cómo mejorar los sistemas, cómo llevar este análisis a todo tipo de contenido audiovisual, a nivel global”, valora Hernández Boza. Y advierte que el próximo reto ya no será solo tratar de identificar un vídeo falso, sino demostrar que un vídeo es real. “Puede que te pillen realizando alguna acción ilícita y tú lo niegues, asegurando que es un deepfake, aunque realmente te hayan pillado. Esto dará los mismos problemas. Necesitaremos identificar y demostrar que el vídeo es real, con metadatos, con varias fuentes, para comprobar que no se ha manipulado. Por lo tanto, la dificultad reside no solo en detectar contenido falso, sino en validar el contenido real: demostrar que no se ha manipulado y realmente sucedió”, concluye.

Más de 1.000 empresarios e investigadores relacionados con la inteligencia artificial –como el fundador de Tesla, Elon Musk, o el cofundador de Apple, Steve Wozniak–, publicaron a finales de marzo una carta abierta en la que solicitaban una moratoria de al menos seis meses en el desarrollo de esta tecnología. El motivo: los últimos avances ya son capaces de competir con los humanos, por lo que podrían usarse para destruir empleo y difundir desinformación. Reclaman un desarrollo seguro que compruebe que sus efectos serán positivos.

En Europa se están dando los primeros pasos para regular el futuro incierto de este tipo de tecnología, con el desarrollo del Reglamento de Inteligencia Artificial (The AI Act), que todavía se está debatiendo en la Unión Europea. Cuando entre en vigor será la primera ley que tenga como objetivo garantizar que los sistemas y aplicaciones de inteligencia artificial que funcionen en Europa sean seguros y respeten los derechos fundamentales y valores de la Unión, al mismo tiempo que aportará un marco jurídico y legal uniforme, que deberán implantar y trasladar los Estados miembros a sus

respectivas normativas.

España ha sido el primer país en anunciar la creación de la Agencia Española de Supervisión de la Inteligencia Artificial (AESIA), que tendrá potestad certificadora y sancionadora, y velará por el cumplimiento del futuro reglamento europeo. La intención era que la AESIA comenzara a trabajar en el verano de 2023, en la sede designada en A Coruña, pero la Sociedad Civil Juntos por Granada y el propio Ayuntamiento de la ciudad andaluza –que competían junto a otras urbes por alojar la sede– han impugnado la designación y ralentizado su puesta en marcha.

“Está por ver cuáles serán las atribuciones de la AESIA y cómo se va a implementar la regulación europea. La apuesta en España parte de que las empresas tengan unos protocolos de seguridad que se puedan auditar. La AESIA debería crear una herramienta de certificación, como un sello de calidad. Si una empresa consigue ese certificado, podrá demostrar que lo está haciendo bien y los ciudadanos podrán confiar en su producto. Un organismo de certificación, amparado por la AESIA, debería tener personal con conocimiento técnico necesario para demostrar, de forma transparente, que se está haciendo un trabajo de acuerdo a unos principios éticos y a la legislación en vigor. Y si no es así: penalización, multas o retirar ese sello”, reflexiona José María Alonso, profesor de Ciencias de la Computación e Inteligencia Artificial en la Universidad de Santiago de Compostela e investigador del CiTIUS.

Los profesionales que trabajen en la futura AESIA tendrán perfiles técnicos y jurídicos, especializados en nuevas tecnologías y seguridad informática. Sin embargo, José María Alonso recuerda la necesidad de añadir a esos perfiles, profesionales de otras disciplinas, como lingüística, sociología o medicina, que aporten su visión sobre posibles usos y abusos de la inteligencia artificial. “No se puede hacer una regulación que solo se base en el conocimiento de ingenieros y abogados. Debería haber paneles de discusión, en los que se combinen todas las visiones, para hacer un desarrollo multidisciplinar inclusivo”, afirma.