Deep fakes. Como a intelixencia artificial pode xerar noticias falsas

Todo comeza cunha pregunta, como a formulada por Lola Flores no que parecía un vídeo inédito que saíu á luz en 2021. “Sabes por que a min si se me entendeu en todo o mundo? Polo acento”, dicía a artista, falecida en 1995, mirando directamente á cámara. Estas imaxes, que parecían reais, pero non o eran, formaban parte dun anuncio dunha marca de cervexa, proporcionando un excelente exemplo do que pode facer a intelixencia artificial (IA).

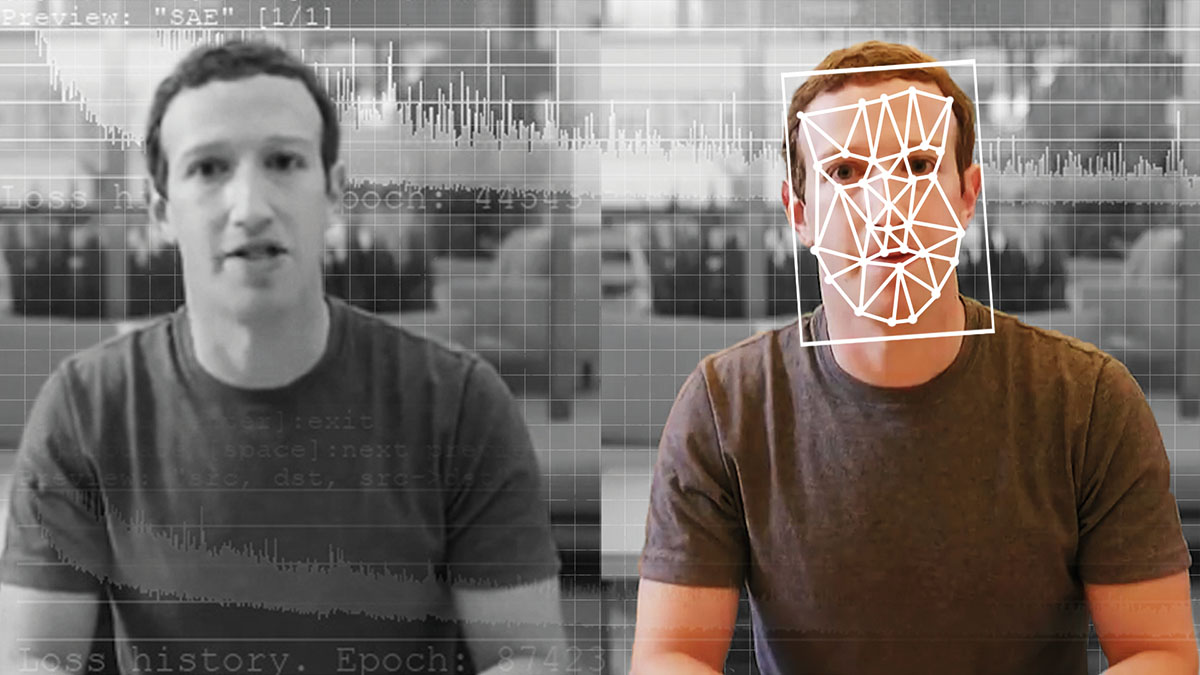

A tecnoloxía que o fixo posible coñécese en inglés como deepfake, ultratrucaxe na nosa lingua, unha técnica de intelixencia artificial que, a partir de vídeos e imaxes preexistentes e a través de software de aprendizaxe automática e algoritmos coñecidos como RXA (Rede Xerativa Antagónica), permite a creación de vídeos, imaxes ou ficheiros de voz falsos e manipulados, pero cun aspecto real e auténtico. E aí radica o perigo.

A orixe dunha mentira

“Podemos definir as ultratrucaxes como contidos textuais ou audiovisuais xerados artificialmente que non se corresponden coa realidade. Poden ser noticias falsas ou vídeos nos que se incorpora o rostro dunha persoa a

unha escena na que non está participando. O máis habitual é todo o relacionado co ámbito político, pero hoxe en día, os contidos falsos e de pouca credibilidade ou incorrectos están moi presentes na web e nas redes sociais”, afirma David Losada, profesor de Ciencias da Computación e Intelixencia Artificial na Universidade de Santiago de Compostela, investigador do Centro Singular de Investigación en Tecnoloxías Intelixentes (CiTIUS).

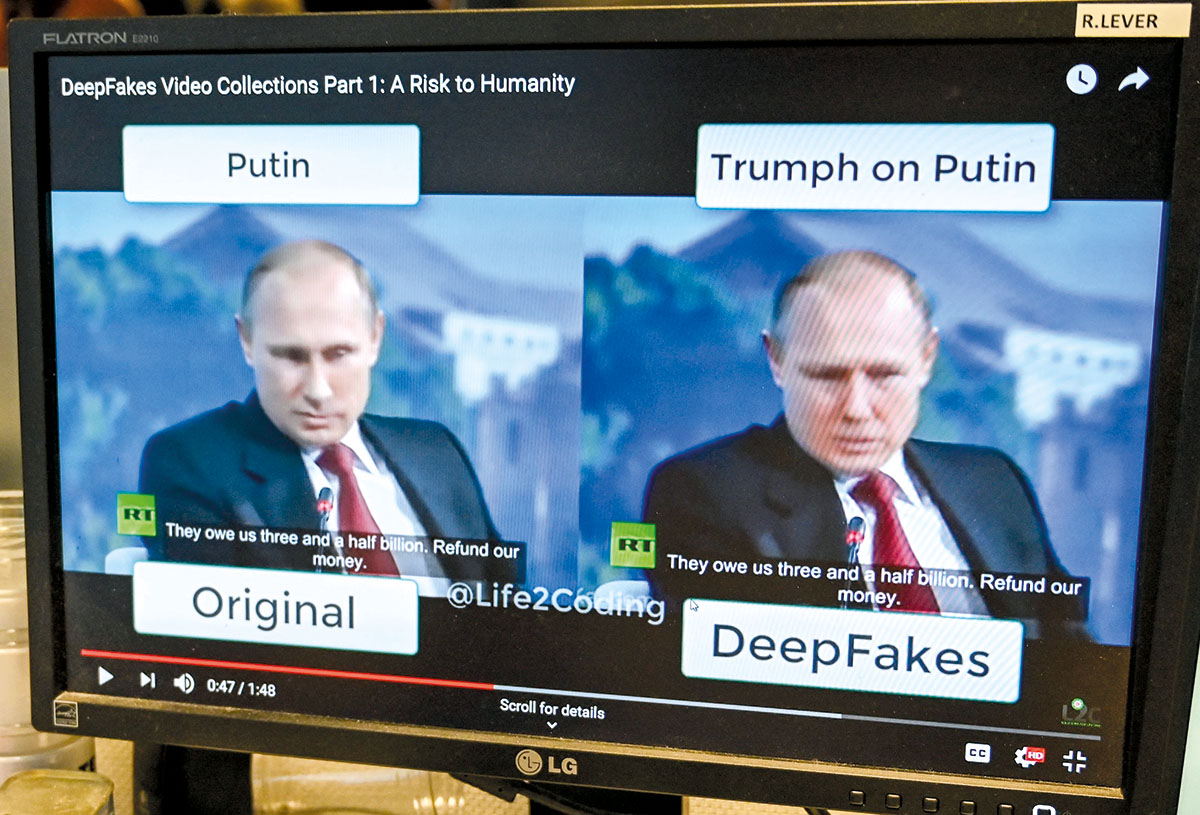

Existen diferentes categorías de ultratrucaxes, entre as que destacan tres: face-swap (troca de rostros) slip-sync (sincronización labial cunha mensaxe de audio) e puppet master (monicreque virtual). Os primeiros vídeos manipulados pola intelixencia artificial dos que se ten constancia remóntanse á década dos noventa, pero saltaron á fama en 2017, cando un fío da plataforma de noticias Reddit publicou vídeos de contido adulto co rostro de actrices famosas.

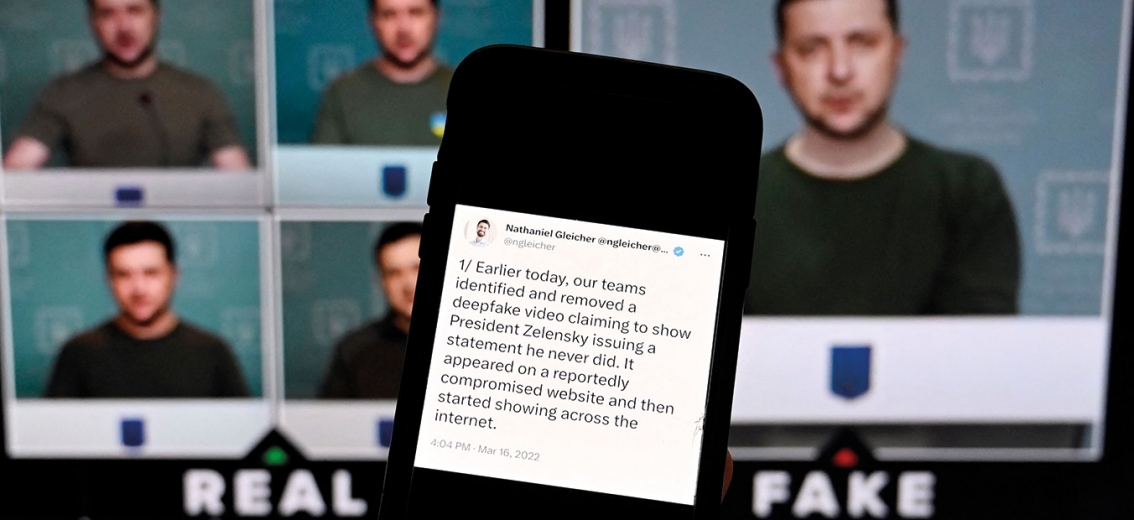

Non rematou aí. Vídeos de altos cargos políticos e presidentes lanzando diatribas que nunca pronunciaron ou de famosos empresarios que anuncian falsas compras millonarias son algúns dos exemplos nos que a ultratrucaxe pode provocar desinformación e tensión social, política ou económica, atacar a intimidade e honra das vítimas de montaxes ou mesmo utilizar a intelixencia artificial para cometer outro tipo de delitos. A finais de 2022 foi detido en Valladolid un pederasta que utilizaba a mesma tecnoloxía para crear ultratrucaxes de abuso sexual infantil. En marzo de 2023, Facebook e Instagram víronse inundados de anuncios dunha aplicación, Deepfake FaceSwap, que utilizaba as caras de actrices famosas en vídeos pornográficos falsos como gancho.

Aínda que as ultratrucaxes son difíciles de destapar, hai algúns signos que nos poden axudar:

- Fallos. Moitos teñen erros que revelan que o vídeo foi manipulado: bordos borrosos, pel artificialmente lisa, movementos bruscos ou diferenzas de iluminación son algúns deles.

- Pestanexo. Nunha ultratrucaxe, unha persoa pestanexa menos veces das que o faría unha persoa nun vídeo real. Isto débese a que o algoritmo non é capaz de pestanexar sen evidenciar indicios de falsidade, polo menos tan rápido como un ser humano.

- Pescozo e cara. Estes vídeos adoitan modificar só os rostros, non o corpo enteiro, xa que isto é máis complicado. Se o que se ve do corpo non coincide coa cara, podemos ter unha pista máis de que se trata dun vídeo falso.

- Son. Moitas veces a imaxe non encaixa correctamente coa voz, polo que non hai sincronización entre o movemento dos beizos e o son.

- Detalles. É importante coñecer toda a información sobre a gravación e para iso pode axudar a reproducir o vídeo a unha velocidade reducida. Se se trata dunha ultratrucaxe, podemos ver cambios bruscos na imaxe ou cambios no fondo do vídeo.

- Boca. Os algoritmos de intelixencia artificial aínda non son capaces de copiar con precisión a lingua, os dentes e o interior da boca ao falar. Un pequeno erro nesta parte indica que estamos ante un vídeo manipulado.

- Orixe. Indagar sobre quen compartiu o ficheiro en primeira instancia e en que redes sociais, así como verificar o contexto no que se publicou e os detalles orixinais do ficheiro, poden axudarnos a detectalo.

- Duración. A maioría das ultratrucaxes teñen unha duración moi curta, uns segundos. Un vídeo demasiado curto e cun contido improbable tamén pode darnos unha pista.

Como identificalas

Os expertos recomendan usar o sentido común e o pensamento crítico ante calquera imaxe ou vídeo inusual. Os medios de comunicación tradicionais teñen equipos de verificadores que tratan de distinguir as imaxes manipuladas das reais —como aconteceu recentemente na guerra de Ucraína— e a recomendación é acudir a fontes oficiais, que antes ou despois desmentirán a información falsa. Tamén se pode observar se no vídeo

dunha persoa vemos un pestanexo inexistente ou non sincronizado, perfís de orellas borrosas ou multiplicadas, nariz e mans distorcidas, perda de nitidez e superposición de rostros nun ángulo de 90 graos.

Do mesmo xeito que existen aplicacións para que o público en xeral, sen coñecementos informáticos, experimente coa intelixencia artificial para crear deepfakes, grandes empresas tecnolóxicas están a desenvolver aplicacións que buscan destapar a desinformación, nunha carreira contra o tempo para evitar o uso malicioso desta tecnoloxía.

“Aínda non hai ferramentas nin software que poidan analizar, en tempo real, todo tipo de contidos, en todo tipo de formatos e plataformas, para que o espectador poida distinguir un vídeo verdadeiro dun falso. É un ámbito incipiente no que cada día aparecen novas ameazas, aínda que existen proxectos de investigación, no ámbito académico e empresarial, para loitar contra iso, porque as grandes compañías son as primeiras interesadas en prestaren un servizo de acceso a información de calidade. Moitas das ferramentas automáticas son de aprendizaxe supervisada, con casos de ultratrucaxe real, intentas ensinarlle ao sistema a distinguir o que é verdade do que é falso”, abunda Losada.

Proxectos como o programa Video Authenticator de Microsoft, ou o algoritmo TREAD, están a traballar nesta liña (Terrorism Reduction with Artificial Intelligence Deepfakes), creada pola Brookings Institution e a Northwestern University dos Estados Unidos, que ten como obxectivo formar os servizos militares e de intelixencia dos países para crear e entender a tecnoloxía deepfake. Outro exemplo é a Coalición para a Procedencia e Autenticidade do Contido, promovida por multinacionais tecnolóxicas co obxectivo de loitar contra a desinformación e desenvolver estándares técnicos que permitan certificar a orixe dos contidos dixitais.

- Cambio de cara. Face-swap

Intercambio facial que substitúe o rostro orixinal por outro, xa sexa de carácter real ou ficticio, que se pode realizar nunha imaxe fixa, vídeo ou transmisión en directo, tal e como permiten aplicacións móbiles como Snapchat ou Face Swap Live.

A empresa de contido xerado por IA, Metaphysic presentou algúns dos mellores exemplos desta tecnoloxía, como a conta viral de TikTok

@DeepTomCruise ou a súa aparición no programa televisivo America’s Got Talent, no que utilizaron esta tecnoloxía para transformar, en directo, o rostro dun concursante no corpo do presentador. Tamén devolveron á vida ao cantante Elvis Presley nunha actuación en directo grazas a esta tecnoloxía. - Unha nova voz. Lip-sync

A partir dun vídeo preexistente, substitúese o contido de audio para simular que dá unha mensaxe diferente. A nova cara encaixará de tal forma que se faga unha sincronización labial.

Un exemplo é o experimento visual proposto por BuzzFeed Video, no que o presidente Barack Obama aparecía nun vídeo emitindo unha mensaxe de advertencia sobre as ultratrucaxes. Nos últimos segundos desvelábase a técnica de lip-sync e o actor que en realidade estaba a pronunciar esa mensaxe. - Fusión de dúas persoas. Puppet-master

É unha das ultratrucaxes máis difíciles e de resultados asombrosos, que consiste en utilizar o corpo dun actor como base para crear un novo vídeo, ao que se superpón e se funde a imaxe doutra persoa. Se, ademais, a isto se lle engaden efectos de audio que recuperan a voz do personaxe orixinal, a ultratrucaxe será aínda máis difícil de detectar.

Un exemplo é o anuncio de Lola Flores para unha marca de cervexa, no que primeiro se gravou como corpo base unha cantora de aparencia similar a Lola Flores. Despois, o deepfake requiriu máis de 5.000 imaxes de arquivo da artista, centos de horas de posprodución, con axustes para garantir a verosimilitude do modelo, efectos especiais e a voz da súa filla.

Destapando a realidade

Nesta liña de investigación, España forma parte dun proxecto pioneiro, liderado polo CiTIUS e coñecido como HYBRIDS: Intelixencia híbrida para supervisar, promover e analizar as transformacións nas boas prácticas democráticas. É dicir: humanos e máquinas loitando xuntos contra a desinformación, as noticias falsas e os discursos de odio. Esta iniciativa, cofinanciada pola Unión Europea e o UK Research and Innovation do Reino Unido, achega a análise científica que poida contrarrestar as ameazas de desinformación. Como o conseguirá? Mediante o desenvolvemento de novas ferramentas automáticas, baseadas no procesamento da linguaxe natural (PNL) e na intelixencia artificial, aplicando técnicas de deep learning (aprendizaxe profunda). “O obxectivo é xerar novos sistemas de interpretación neurosimbólica, algo que coñecemos como ‘intelixencia híbrida’, que consiste en combinar as altas capacidades computacionais dos algoritmos neuronais co coñecemento humano, para superar as carencias dos métodos actuais de intelixencia artificial”, describe Pablo Gamallo, experto en lingüística computacional e responsable de HYBRIDS en España.

Así se verifica

A dificultade para o espectador á hora de identificar a manipulación visual ten que ver co rápido consumo de contidos nas redes sociais, a falta de espírito crítico que leva a caer en boatos e a propia dificultade técnica para diferenciar o contido falso do real. O crecemento das ultratrucaxes está a ser exponencial, case se duplica cada seis meses desde 2018, segundo un informe de Sensity, empresa dedicada á detección e verificación de contidos.

“Temos algúns casos recentes, moi visuais, de ultratrucaxes. Un exemplo poderían ser as fotografías das manifestacións en Francia de febreiro de 2023 nas que aparecían unidades de intervención policial consolando os manifestantes ou portando un oso de peluche. Aconteceu? Non. Eran imaxes xeradas integramente pola intelixencia artificial, cun certo toque inocente, pero, que pasaría se en lugar dun abrazo se comparte a imaxe de presuntas accións violentas, que dean pé a disturbios?”, reflexiona Miguel Hernández Boza, analista de seguridade da información, especializado en detección de fraudes e seguridade defensiva.

De feito, as fotografías ficticias das manifestacións contra a reforma da xubilación en Francia foron rapidamente refutadas pola experta en verificación Nina Lamparski, directora da plataforma AFP FastCheck. A pista definitiva? Un rostro con orella dobre e mans con seis dedos. Á intelixencia artificial aínda lle custa deseñar algúns aspectos da fisonomía humana, pero abre unha nova fronte aos xornalistas e verificadores de información, que no futuro deberán contrastar todas as imaxes que reciban como supostamente reais e detectar ese tipo de erros.

“A DARPA, a Axencia de Proxectos de Investigación Avanzados de Defensa dos Estados Unidos, é a que máis avanzou na investigación. Xa prediciran hai anos que o maior perigo ao que se pode enfrontar a sociedade é a combinación de voces, vídeo e imaxes para crear feitos falsos. Este traballo da DARPA podería servir de base para outros proxectos internacionais que loitan contra a desinformación, para non comezar de cero. Poderíase continuar a partir da súa experiencia sobre como facilitar a detección, como mellorar os sistemas, como aplicar esta análise a todo tipo de contido audiovisual, a nivel global”, valora Hernández Boza. E advirte que o próximo reto xa non será só tentar identificar un vídeo falso, senón demostrar que un vídeo é real. “É posible que te apañen cometendo unha acción ilícita e o negues, asegurando que se trata dunha ultratrucaxe, aínda que realmente te apañasen. Isto dará os mesmos problemas. Precisaremos identificar e demostrar que o vídeo é real, con metadatos, con diversas fontes, para comprobar que non foi manipulado. Polo tanto, a dificultade non só radica en detectar contidos falsos, senón en validar o contido real: demostrar que non foi manipulado e que realmente sucedeu”, conclúe.

Máis de 1.000 empresarios e investigadores relacionados coa intelixencia artificial -como o fundador de Tesla, Elon Musk, ou o cofundador de Apple, Steve Wozniak- publicaron a finais de marzo unha carta aberta na que pedían unha moratoria de polo menos seis meses, no desenvolvemento desta tecnoloxía. O motivo: os últimos avances xa son capaces de competir cos humanos, polo que poderían ser utilizados para destruír postos de traballo e difundir desinformación. Esixen un desenvolvemento seguro que demostre que os seus efectos serán positivos.

En Europa, estanse a dar os primeiros pasos para regular o incerto futuro deste tipo de tecnoloxías, co desenvolvemento do Regulamento de Intelixencia Artificial (The AI Act), que aínda se está a debater na Unión Europea. Cando entre en vigor, será a primeira lei que teña como obxectivo garantir que os sistemas e aplicacións de IA que operen en Europa sexan seguros e respecten os dereitos fundamentais e valores da Unión, ao tempo que proporcionará un réxime xurídico e legal uniforme, que deberán implantar e trasladar os estados membros ás súas respectivas normativas.

España foi o primeiro país en anunciar a creación da Axencia Española de Supervisión da Intelixencia Artificial (AESIA), que terá potestade certificadora e sancionadora, e velará polo cumprimento do futuro regulamento europeo.

A intención era que a AESIA comezase a traballar no verán de 2023, na sede designada na Coruña, pero a Sociedade Civil Juntos por Granada e o propio concello da cidade andaluza –que competían con outras urbes para acoller a sede– impugnaron a designación e retardaron a súa posta en marcha.

“Está por ver cales serán as competencias da AESIA e como se aplicará a normativa europea. A aposta en España parte de que as empresas teñan uns protocolos de seguridade, que se poidan auditar. A AESIA debería crear unha ferramenta de certificación, como un selo de calidade. Se unha empresa consegue ese certificado, poderán demostrar que o está facendo ben e que os cidadáns poden confiar no seu produto. Un organismo de certificación, amparado pola AESIA, debería contar con persoal cos coñecementos técnicos necesarios para demostrar, de forma transparente, que se está a realizar un traballo en IA de acordo cuns principios éticos, de acordo cunha regulación. E se non é así: penalización, multas ou retirar ese selo”, reflexiona José María Alonso, profesor de Ciencias da Computación e Intelixencia Artificial na Universidade de Santiago de Compostela e investigador do CiTIUS.

Os profesionais que traballen na futura AESIA terán perfís técnicos e xurídicos, especializados en novas tecnoloxías e seguridade informática. Con todo, José María Alonso lembra a necesidade de engadir a eses perfís, profesionais doutras disciplinas, como lingüística, socioloxía ou medicina, que acheguen a súa visión sobre posibles usos e abusos da intelixencia artificial. “Non se pode facer unha regulación que só se basee no coñecemento de enxeñeiros e avogados. Debería haber paneis de discusión, nos que se combinen todas as visións, para facer un desenvolvemento multidisciplinar inclusivo”, afirma.